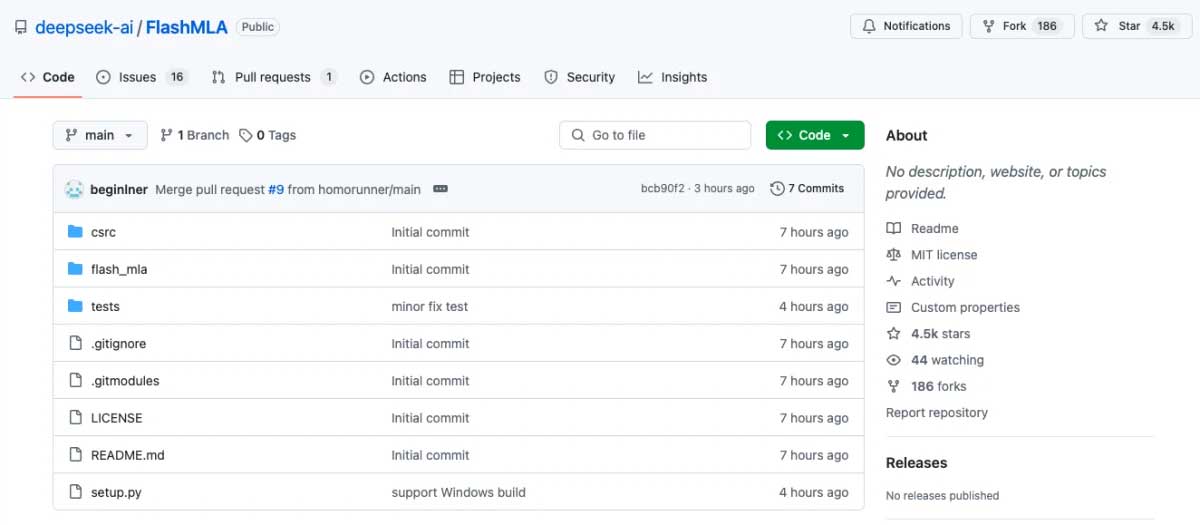

2月21日,深度求索(DeepSeek)公司在全球範圍內發佈了其首個開源項目 — ”Flash MLA"。這一創新技術是 Nvidia® Hopper GPU 進行優化的高效解碼器核心,專為處理可變長度序列而設計,已經成功投入生產,並在 GitHub 上獲得了超過 4.5k 的星號。

技術亮點與性能表現

- 定制化優化 :Flash MLA 專為中英雙語場景進行定制,提供更高效的處理能力。

- 性能指標 :

- 在 H800 SXM5 平臺上,使用 CUDA 12.6,Flash MLA 在記憶體受限環境下實現了 3000GB/s 的資料處理速度。

- 計算性能達到了 580 TFLOPS,在資源有限的環境中展現出卓越的計算能力。

- 技術基礎 :該專案借鑒了英特爾推出的 FlashAttention(版本 2 和 3)和 NVIDIA 開發的 CUTLASS 庫,確保了高效計算的實現。

技術創新

Flash MLA 在以下方面展現出獨特優勢:

- 潛變數壓縮 :通過將鍵值資訊壓縮為低維表示,在保持計算完整性的同時顯著降低記憶體佔用。

- 低秩變換 :針對查詢對象進行優化,減少啟動記憶的使用量,而不會影響鍵值緩存性能。

- 動態序列處理 :能夠高效處理不同長度的輸入序列,適應長文本、對話等複雜場景。

對模型訓練的意義

Flash MLA 的推出顯著降低了大型語言模型的計算和記憶體需求,使先進的 AI 應用更加高效且可擴展。這一突破性成果鞏固了深度求索在潛注意力機制研究領域的地位,成為行業標杆。

創新意義

該項目不僅展示了深度求索在技術創新方面的實力,也體現了其在 AI 領域的領先地位。通過開源,這一技術為全球研究者和開發者提供了寶貴的資源,推動了整個行業的進步。

結語

Flash MLA 的問世,為 DeepSeek 的研發歷程增添了濃墨重彩的一筆,也為人工智慧技術的發展注入了新的活力。未來,我們期待看到更多基於這一創新技術的應用,推動更廣泛的行業變革。